Le concept de représentation des données dans les systèmes informatiques est fondamental pour comprendre le fonctionnement des ordinateurs. La représentation des types de données et des nombres revêt une importance particulière, car elle détermine la manière dont les informations sont stockées, manipulées et interprétées par les machines. En informatique, les données sont généralement représentées sous forme binaire, c’est-à-dire en utilisant uniquement deux symboles, généralement 0 et 1, qui correspondent à l’état de circuits électroniques.

Pour commencer, examinons la représentation des types de données. Dans un système informatique, différents types de données peuvent être représentés, tels que les caractères, les nombres entiers, les nombres à virgule flottante, les booléens, etc. Chaque type de données a sa propre manière de représentation binaire. Par exemple, les caractères peuvent être représentés à l’aide de codes ASCII ou Unicode, où chaque caractère est associé à un code numérique unique.

En ce qui concerne les nombres, ils peuvent être représentés de différentes manières selon leur type. Les nombres entiers sont souvent représentés en utilisant la notation binaire, où chaque chiffre binaire (0 ou 1) correspond à une puissance de 2. Par exemple, le nombre binaire 1011 représente le nombre décimal 11. De même, les nombres à virgule flottante sont représentés en utilisant la norme IEEE 754, qui divise le nombre en parties fractionnaires et exponentielles pour permettre une représentation précise des nombres réels.

En outre, il est important de comprendre la manière dont les nombres sont signés ou non signés. Les nombres signés peuvent être positifs ou négatifs, tandis que les nombres non signés sont toujours positifs. La représentation des nombres signés peut se faire selon plusieurs méthodes, telles que le complément à deux, où le bit le plus à gauche est utilisé pour indiquer le signe du nombre.

En ce qui concerne la représentation des nombres dans les systèmes informatiques, il est également crucial de comprendre les limites de représentation. Par exemple, un nombre sur un certain nombre de bits peut représenter un nombre limité de valeurs. Ainsi, un entier codé sur 32 bits peut représenter des valeurs de -2^31 à 2^31-1 dans le cas du complément à deux.

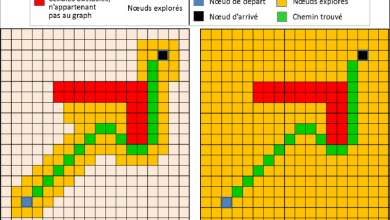

Outre les nombres et les types de données classiques, les systèmes informatiques peuvent également représenter d’autres informations, telles que des images, des vidéos, des sons, etc. Chaque type de donnée a ses propres méthodes de représentation et de stockage, souvent basées sur des formats de fichier spécifiques et des algorithmes de compression.

En résumé, la représentation des types de données et des nombres dans les systèmes informatiques est un domaine vaste et essentiel de l’informatique. Comprendre comment les données sont représentées et traitées par les ordinateurs est crucial pour développer des logiciels efficaces et pour résoudre des problèmes complexes en informatique.

Plus de connaissances

Bien sûr, explorons plus en détail la représentation des types de données et des nombres dans les systèmes informatiques.

-

Représentation des caractères:

Les caractères sont souvent représentés à l’aide de codes de caractères tels que ASCII (American Standard Code for Information Interchange) ou Unicode. ASCII utilise 7 bits pour représenter chaque caractère, permettant ainsi la représentation de 128 caractères différents, allant des lettres majuscules et minuscules aux chiffres et symboles spéciaux. Unicode, en revanche, est une norme de codage de caractères qui utilise un espace de codage beaucoup plus large, permettant de représenter des milliers de caractères différents, y compris des caractères de différentes langues et des symboles spéciaux. -

Représentation des nombres entiers:

Les nombres entiers peuvent être représentés de différentes manières, telles que la notation binaire (base 2), la notation octale (base 8), la notation décimale (base 10) ou la notation hexadécimale (base 16). La représentation binaire est la plus couramment utilisée dans les systèmes informatiques en raison de sa compatibilité avec le matériel électronique. Les nombres entiers peuvent être signés ou non signés, et leur représentation varie en conséquence. -

Représentation des nombres à virgule flottante:

Les nombres à virgule flottante sont utilisés pour représenter des nombres réels et sont souvent représentés selon la norme IEEE 754. Cette norme spécifie la manière de représenter les nombres en virgule flottante à l’aide de bits pour la partie fractionnaire, la partie exponentielle et le signe. Les nombres à virgule flottante sont utilisés dans de nombreuses applications informatiques, telles que le calcul scientifique, la modélisation physique et les graphiques 3D. -

Représentation des nombres binaires signés:

Les nombres binaires signés sont souvent représentés en utilisant le complément à deux. Dans cette méthode, le bit le plus à gauche est utilisé pour indiquer le signe du nombre (0 pour positif, 1 pour négatif). Le reste des bits représente la valeur absolue du nombre, et pour les nombres négatifs, le complément à deux est utilisé pour représenter la valeur négative. -

Représentation des autres types de données:

En dehors des caractères et des nombres, les systèmes informatiques doivent également représenter d’autres types de données tels que les images, les vidéos, les sons, etc. Chaque type de données a ses propres méthodes de représentation et de stockage. Par exemple, les images peuvent être représentées à l’aide de formats de fichier tels que JPEG, PNG ou GIF, tandis que les vidéos peuvent être représentées à l’aide de formats tels que MP4, AVI ou MKV.

En comprenant la manière dont les données sont représentées dans les systèmes informatiques, les programmeurs peuvent écrire des logiciels efficaces et robustes, et les ingénieurs peuvent concevoir des systèmes matériels optimisés pour le traitement de ces données. La représentation des données est donc un aspect essentiel de l’informatique moderne, avec des implications dans de nombreux domaines, de la programmation aux réseaux en passant par l’intelligence artificielle et l’informatique embarquée.