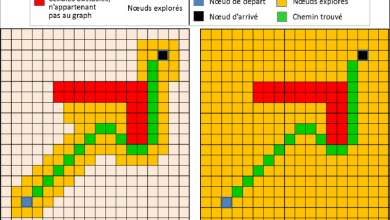

L’analyse des algorithmes est un domaine fondamental de l’informatique qui étudie la performance et le comportement des algorithmes. Un algorithme peut être défini comme une séquence finie et non ambiguë d’instructions ou de règles qui décrit comment résoudre un problème ou exécuter une tâche spécifique. L’analyse des algorithmes vise à évaluer divers aspects des algorithmes, tels que leur efficacité, leur complexité, leur exactitude et leur optimisation.

L’efficacité d’un algorithme se réfère généralement à la quantité de ressources nécessaires pour exécuter l’algorithme, telles que le temps et l’espace. Le temps d’exécution d’un algorithme est mesuré en fonction de la quantité de temps nécessaire pour résoudre un problème, tandis que l’espace mémoire utilisé par un algorithme se réfère à la quantité de mémoire requise pour exécuter l’algorithme. L’analyse de la complexité des algorithmes vise à évaluer comment le temps d’exécution et l’espace mémoire nécessaires augmentent en fonction de la taille de l’entrée du problème. Cette évaluation est cruciale pour déterminer la faisabilité de l’utilisation d’un algorithme pour résoudre un problème donné, en particulier pour des problèmes de grande taille où les ressources sont limitées.

La solution définitive pour raccourcir les liens et gérer vos campagnes digitales de manière professionnelle.

• Raccourcissement instantané et rapide des liens

• Pages de profil interactives

• Codes QR professionnels

• Analyses détaillées de vos performances digitales

• Et bien plus de fonctionnalités gratuites !

Il existe plusieurs approches pour analyser les algorithmes. L’approche la plus courante consiste à utiliser la notation de Landau, également connue sous le nom de notation O (grand O). Cette notation fournit une estimation de la limite supérieure du comportement asymptotique d’une fonction. Par exemple, si un algorithme a une complexité temporelle de O (n²), cela signifie que le temps d’exécution de l’algorithme est proportionnel au carré de la taille de l’entrée du problème. La notation O fournit une manière concise et standardisée de comparer la complexité des algorithmes et de prédire leur performance pour des problèmes de grande taille.

Une autre approche courante dans l’analyse des algorithmes est l’utilisation de la notation Ω (oméga) pour décrire la limite inférieure du comportement asymptotique d’une fonction, ainsi que la notation Θ (thêta) pour décrire à la fois la limite supérieure et inférieure. Ces notations complémentaires aident à fournir une vue plus complète du comportement d’un algorithme dans le meilleur et le pire des cas.

Outre l’évaluation de la complexité temporelle et spatiale, l’analyse des algorithmes comprend également l’étude de leur exactitude et de leur optimisation. La précision d’un algorithme se réfère à sa capacité à produire des résultats corrects pour tous les cas possibles, tandis que l’optimisation vise à améliorer les performances d’un algorithme en réduisant son temps d’exécution ou son utilisation de la mémoire sans compromettre sa précision. L’optimisation des algorithmes peut impliquer des techniques telles que la récursivité, la programmation dynamique, la conception de structures de données efficaces et l’utilisation de heuristiques.

En résumé, l’analyse des algorithmes est un domaine crucial de l’informatique qui évalue la performance, la complexité, l’exactitude et l’optimisation des algorithmes. En comprenant ces aspects, les informaticiens peuvent concevoir, analyser et améliorer les algorithmes pour résoudre efficacement une variété de problèmes informatiques.

Plus de connaissances

Bien sûr, plongeons un peu plus en profondeur dans l’analyse des algorithmes.

L’une des premières étapes dans l’analyse des algorithmes consiste à déterminer la mesure de la taille de l’entrée du problème. Cette mesure varie en fonction du type de problème que l’algorithme cherche à résoudre. Par exemple, pour les algorithmes de tri, la taille de l’entrée peut être le nombre d’éléments dans la liste à trier. Pour les algorithmes de recherche, la taille de l’entrée peut être la taille de la structure de données dans laquelle la recherche est effectuée.

Une fois que la taille de l’entrée est déterminée, l’analyse des algorithmes vise à évaluer comment le temps d’exécution et l’espace mémoire requis par l’algorithme augmentent en fonction de cette taille. Pour ce faire, différentes méthodes d’analyse peuvent être utilisées, notamment :

-

Analyse de pire cas : Cette méthode évalue la performance de l’algorithme dans le pire des scénarios possibles. Elle fournit une garantie sur le temps d’exécution maximal de l’algorithme pour toutes les entrées de taille donnée.

-

Analyse de meilleur cas : Contrairement à l’analyse de pire cas, cette méthode évalue la performance de l’algorithme dans le meilleur des scénarios possibles. Cependant, elle est moins utilisée car elle ne fournit pas une indication réaliste de la performance générale de l’algorithme.

-

Analyse en moyenne : Cette méthode évalue la performance de l’algorithme sur une distribution probabiliste des entrées. Elle est utile lorsque les performances de l’algorithme varient en fonction de la nature des entrées.

-

Analyse amortie : Cette méthode est utilisée pour évaluer la performance des structures de données dynamiques, telles que les listes, les files d’attente et les tables de hachage. Elle évalue le coût moyen d’une séquence d’opérations sur la structure de données plutôt que le coût individuel de chaque opération.

En plus de ces méthodes d’analyse, il existe des techniques pour classer les algorithmes en fonction de leur complexité. Par exemple, un algorithme est dit de complexité temporelle polynomiale s’il s’exécute en un temps qui est une fonction polynomiale de la taille de l’entrée. D’autre part, un algorithme est considéré comme de complexité temporelle exponentielle s’il s’exécute en un temps qui est une fonction exponentielle de la taille de l’entrée. Les algorithmes de complexité exponentielle sont souvent considérés comme inefficaces pour les entrées de grande taille en raison de leur temps d’exécution prohibitif.

En outre, l’analyse des algorithmes peut également inclure des considérations sur la stabilité, la robustesse et la parallélisme des algorithmes. La stabilité d’un algorithme fait référence à sa capacité à maintenir l’ordre relatif des éléments égaux dans l’entrée. La robustesse d’un algorithme se réfère à sa capacité à gérer des entrées incorrectes ou imprévues sans planter ou produire des résultats incorrects. Le parallélisme des algorithmes fait référence à leur capacité à être exécutés de manière efficace sur des systèmes informatiques parallèles ou distribués.

En conclusion, l’analyse des algorithmes est une discipline complexe et fondamentale de l’informatique qui joue un rôle essentiel dans la conception, l’optimisation et l’évaluation des algorithmes. En comprenant la performance et la complexité des algorithmes, les informaticiens peuvent choisir les meilleurs outils pour résoudre une variété de problèmes informatiques, des tâches simples aux défis les plus complexes.