L’apprentissage automatique, ou machine learning en anglais, est un domaine de l’intelligence artificielle qui permet aux systèmes informatiques d’apprendre à partir de données et de prendre des décisions sans être explicitement programmés pour chaque tâche. Il repose sur l’idée que les systèmes peuvent apprendre des données, identifier des motifs et prendre des décisions avec un minimum d’intervention humaine. Dans cet univers fascinant, plusieurs modèles et techniques sont utilisés pour résoudre une variété de problèmes, allant de la reconnaissance d’images à la prédiction de séries temporelles.

L’un des modèles les plus fondamentaux en apprentissage automatique est celui des réseaux de neurones artificiels, inspiré du fonctionnement du cerveau humain. Ces réseaux sont composés de neurones interconnectés qui transmettent des signaux les uns aux autres. Les réseaux de neurones profonds, ou réseaux neuronaux profonds, sont une extension de cette idée, avec plusieurs couches de neurones interconnectés, permettant ainsi de modéliser des données complexes.

La solution définitive pour raccourcir les liens et gérer vos campagnes digitales de manière professionnelle.

• Raccourcissement instantané et rapide des liens

• Pages de profil interactives

• Codes QR professionnels

• Analyses détaillées de vos performances digitales

• Et bien plus de fonctionnalités gratuites !

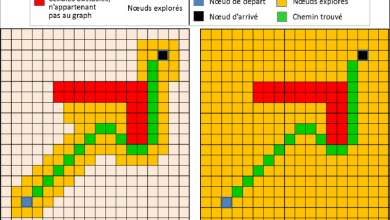

Un autre modèle largement utilisé est celui des arbres de décision, qui modélisent les décisions sous forme d’arbres. Chaque nœud de l’arbre représente une caractéristique (ou attribut), chaque branche représente une décision basée sur cette caractéristique, et chaque feuille représente un résultat. Les arbres de décision sont simples à interpréter et peuvent gérer à la fois des données numériques et catégorielles.

Les machines à vecteurs de support (SVM) sont également populaires en raison de leur efficacité dans la classification des données. Ils cherchent à trouver un hyperplan optimal qui sépare les différentes classes d’observations dans un espace multidimensionnel. Les SVM sont largement utilisés dans la classification de texte, la reconnaissance de visages et la bioinformatique.

En ce qui concerne les techniques d’apprentissage non supervisé, les algorithmes de regroupement (clustering) sont souvent utilisés. Le K-means est l’un des algorithmes de regroupement les plus simples et les plus largement utilisés. Il vise à partitionner un ensemble de données en un nombre prédéfini de groupes homogènes. Le regroupement hiérarchique est une autre approche où les données sont regroupées de manière itérative pour former une hiérarchie de clusters.

Pour évaluer les performances des modèles d’apprentissage automatique, diverses mesures sont utilisées, telles que la précision, le rappel, la F-mesure et la courbe ROC. Ces mesures permettent d’évaluer la capacité d’un modèle à généraliser à de nouvelles données et à éviter le surajustement (overfitting).

En matière de choix de modèle, il n’existe pas de solution universelle. Le choix du modèle dépend du problème à résoudre, de la nature des données et des contraintes spécifiques du projet. Par exemple, pour la classification d’images, les réseaux de neurones convolutionnels (CNN) sont souvent préférés en raison de leur capacité à capturer les motifs spatiaux dans les images. Pour les problèmes de régression, les méthodes comme la régression linéaire, les arbres de décision ou les réseaux de neurones peuvent être explorées en fonction de la complexité des relations entre les variables.

En résumé, l’apprentissage automatique offre un éventail de modèles et de techniques pour résoudre une multitude de problèmes. Le choix du modèle dépend de divers facteurs et nécessite une compréhension approfondie du problème à résoudre et des données disponibles. En expérimentant avec différents modèles et en évaluant leurs performances, les praticiens de l’apprentissage automatique peuvent trouver des solutions efficaces et adaptées à leurs besoins spécifiques.

Plus de connaissances

Bien sûr, explorons davantage le domaine fascinant de l’apprentissage automatique.

Outre les modèles mentionnés précédemment, il existe une multitude d’autres techniques et approches en apprentissage automatique, chacune avec ses propres forces et faiblesses.

-

Réseaux de neurones récurrents (RNN) : Contrairement aux réseaux de neurones traditionnels, les RNN sont conçus pour traiter des données séquentielles en maintenant une mémoire interne. Ils sont largement utilisés dans des tâches telles que la traduction automatique, la génération de texte et l’analyse de séries temporelles.

-

Méthodes d’ensemble : Les méthodes d’ensemble combinent plusieurs modèles de base pour améliorer les performances de prédiction. Des techniques telles que le bagging, le boosting et les forêts aléatoires sont couramment utilisées pour réduire le surajustement et améliorer la généralisation des modèles.

-

Algorithmes de réduction de dimensionnalité : Lorsque les données présentent un grand nombre de variables, les algorithmes de réduction de dimensionnalité peuvent être utilisés pour extraire les caractéristiques les plus importantes et réduire la complexité du modèle. Des techniques telles que l’analyse en composantes principales (PCA) et la sélection de variables peuvent être utilisées à cette fin.

-

Apprentissage par renforcement : Cette branche de l’apprentissage automatique repose sur le principe de l’apprentissage par essais et erreurs. Les agents apprennent à prendre des décisions en interagissant avec un environnement et en recevant des récompenses ou des sanctions en fonction de leurs actions. Les applications courantes incluent les jeux, la robotique et la gestion de portefeuille.

-

Apprentissage semi-supervisé et non supervisé : Contrairement à l’apprentissage supervisé, où les données sont entièrement étiquetées, l’apprentissage semi-supervisé utilise à la fois des données étiquetées et non étiquetées pour entraîner le modèle. L’apprentissage non supervisé, quant à lui, vise à découvrir la structure sous-jacente des données sans utiliser d’étiquettes. Ces approches sont utilisées dans des domaines tels que la détection d’anomalies et la segmentation d’images.

-

Optimisation hyperparamétrique : Pour obtenir les meilleurs résultats, les modèles d’apprentissage automatique nécessitent souvent un réglage minutieux des hyperparamètres. L’optimisation hyperparamétrique consiste à rechercher les combinaisons les plus appropriées de paramètres pour maximiser les performances du modèle.

-

Interprétabilité des modèles : Avec l’augmentation de l’adoption des modèles d’apprentissage automatique dans des domaines sensibles tels que la santé et la finance, l’interprétabilité des modèles est devenue une préoccupation majeure. Des techniques telles que les cartes de chaleur, les perturbations de caractéristiques et les méthodes de Lime (Local Interpretable Model-agnostic Explanations) sont utilisées pour expliquer les décisions prises par les modèles.

-

Détection et correction des biais : Les modèles d’apprentissage automatique peuvent refléter les biais présents dans les données d’entraînement, ce qui peut conduire à des résultats injustes ou discriminatoires. Des techniques telles que l’équilibrage des classes, la collecte de données éthiques et la modification des algorithmes sont utilisées pour atténuer ces biais et promouvoir l’équité dans les systèmes d’IA.

En résumé, l’apprentissage automatique est un domaine en constante évolution, avec une grande diversité de modèles, de techniques et d’applications. Les praticiens de l’apprentissage automatique doivent être à l’affût des dernières avancées dans le domaine et être capables de choisir et de personnaliser les approches les plus appropriées pour résoudre efficacement les problèmes rencontrés.